非営利のAI研究会社であるOpenAIの研究者たちは、画像を正確に特定し説明するだけでなく、自然言語のユーザープロンプトに基づいて画像を作成できる2つの新しいニューラルネットワークを開発しました。

「これらのニューラルネットワークは、マルチモーダルAIシステムへの意義ある一歩を表していると信じています」と、同社の発表で述べています。

We’ve developed two neural networks which have learned by associating text and images. CLIP maps images into categories described in text, and DALL-E creates new images, like this, from text.

— OpenAI (@OpenAI) January 5, 2021

A step toward systems with deeper understanding of the world. https://t.co/rppy6u1zcn pic.twitter.com/MNVlo8LZbV

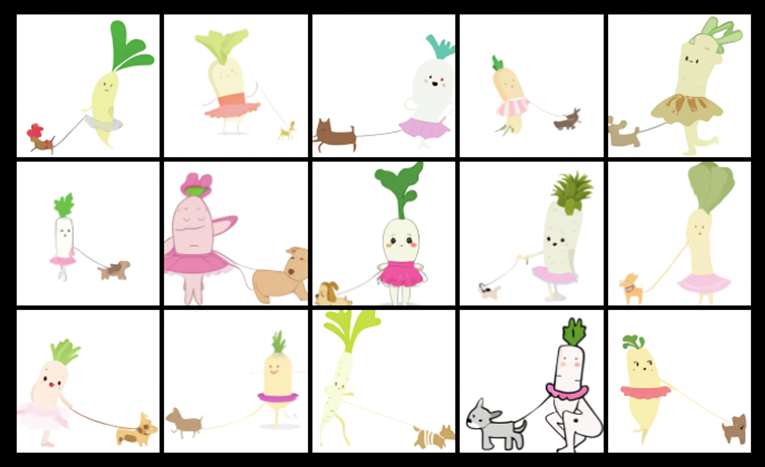

そのうちの一つであるDALL-Eは、シンプルなテキストの説明から画像や写真、レンダリングを作成します。その名前は、有名なアーティストであるサルバドール・ダリ(Dali)と、同名のアニメキャラクターであるロボットのWALL-Eに由来しています。つまり、ロボットと人間の中間のようなものです。

DALL-E — our new neural network for generating images from text:https://t.co/HMGw12LPDd pic.twitter.com/XEnUJOGsc6

— Greg Brockman (@gdb) January 5, 2021

もう一つのCLIPは、シンプルな説明に基づいてオブジェクトを特定し分類します。

DALL-Eが提供する画像は、ニューラルネットワークによって独立して生成されます。これは、OpenAIが開発したGPT-3(Generative Pre-trained Transformer 3)の縮小版であり、事前にトレーニングされたアルゴリズムとディープラーニングを使用して、人間のようなテキストやソフトウェアコードを生成します。この場合、テキスト-画像ペアが特定のアルファベットからの「トークン」の連続として提示されます。

このニューラルネットワークは、服、インテリア、家具、食べ物、動物の画像を作成できます。例えば、「チュチュを着て犬を散歩させる赤ちゃん大根のイラスト」や「アボカドの形をしたアームチェア」などのクエリに対して画像を生成できます。

OpenAIが開発したもう一つのニューラルネットワークであるCLIPは、単一の単語タグではなく、全体の説明に基づいて画像に何が表示されているかを認識することができます。

「ディープラーニングには大量のデータが必要であり、視覚モデルは伝統的に手動でラベリングされたデータセットでトレーニングされてきましたが、これは構築が高価で、限定された数の事前定義された視覚的概念に対してのみ監督を提供します。それに対して、CLIPは既にインターネット上で公開されているテキスト-画像ペアから学習します」とCLIPの研究者は詳述しています。

提示されたOpenAIプロジェクトは、人工知能が適用できるタスクの範囲を広げます。この強力な技術は、将来的にさらに素晴らしくエキサイティングなものに成長する可能性があります。